AB test: як його проводити та що для цього потрібно. AB test: як його проводити і що для цього потрібно Що таке ab тестування

Різкий стрибокконверсії не відбивається на продажах? А може його просто не існує? Якщо засновувати рішення на хибних підсумках тесту, у кращому випадку ви втрачаєте шанс оптимізації, у гіршому – знижуєте конверсію.

На щастя, є спосіб це запобігти. Що таке A/A тестування, як його провести – читайте у статті.

Хибнопозитивний результат

Припустимо, ви оцінюєте комбінації кнопки та заголовка. Коли достовірність сягає 99%, робите висновки та застосовуєте практично.

За кілька бізнес-циклів спостерігаєте: оновлений дизайн не приносить очікуваного прибутку. Адже ви проводили тестування, вкладали в нього час та ресурси!

Це хибнопозитивний результат, відомий також, як «статистична помилка першого типу» та «помилкове відхилення вірної нульової гіпотези». Він зустрічається частіше, ніж ви думаєте – приблизно у 80% випадків.

Чому це відбувається?

Ефект інструменту

На початку експерименту важливо переконатися, що конфігурація інструменту правильна і працює як треба. Інакше - ризик отримати:

- Неправильні показники. Усього одна помилка може спотворити дані A/B тестування. Як мінімум, інтегруйте з Google Analytics для перевірки.

- Неправильне відображення посадкової сторінки. Переконайтеся, що лендинги мають коректний вигляд на всіх пристроях і браузерах, і відвідувачі не стикаються з фліккер-ефектом.

- викликає цю проблему.Передчасне завершення тесту

. Іноді софт оголошує «переможця» занадто рано – при недостатньому розмірі або репрезентативності вибірки. Пам'ятайте: якщо ви досягли статистичної значущості, це не означає, що настав час припиняти тест. Чим він довший, тим точніше результати.

Дивіться обидва: будь-які з цих ознак ведуть до помилкового висновку. Відстежуйте кожну мету та метрику. Якщо будь-який показник не фіксується (наприклад, додавання товару в кошик), зупиніть тест, усуньте проблему та почніть знову.

A/A vs A/B

A/B тест приганяє трафік на контрольну версію та варіацію та показує, яка працює краще.

A/A - те саме, тільки для двох однакових сторінок. Мета - не побачити відмінностей у їхніх показниках. Лише 20% експериментів дають достовірні результати. Статистичної значущості та великої репрезентативної вибірки недостатньо. Тому професіонали використовують цю техніку A/B тест.

Як бачите, ці типи доповнюють одне одного.

Якщо наприкінці експерименту показники конверсії обох сторінок збігаються, можна запускати A/B тест. Насправді не завжди все проходить гладко.

Приклад 1. Як сторінка може переграти свій клон

Це лендинг, який тестувала команда Copyhackers у листопаді 2012 року:

Через 6 днів система тестування відзначила варіант, що «переміг», при рівні достовірності 95%. Для точності експеримент продовжили на день - і досягли 99,6% точності:

Сторінка на 24% ефективніша, ніж така сама? Результат хибнопозитивний. Ще через 3 дні відмінності зникли:

Висновок: тест дуже рано вирахував переможця.

Приклад 2. Як нічого не робити та підвищити конверсію на 300%

Що ми бачимо:

- 9% - зростання показника відкриття листів;

- На 300% зросла кількість переходів за посиланнями;

- На 51% упав показник відписок від розсилки.

І все б нічого, але це A/A тест! Контент, який конкурує один з одним, є абсолютно ідентичним.

Чи варто проводити A/A тести

Відомий експерт Ніл Патель спостерігав великі стрибки конверсії без збільшення виторгу. Він радить насамперед тестувати софт, щоб потім не розхльобувати наслідки невірних рішень.

На думку Піпа Лайя, засновника агентства ConversionXL, тести самі по собі витрачання часу.

Кому вірити? З одного боку, точність понад усе, і метод A/A - спосіб її забезпечити. З іншого боку - витрата ресурсів на тестування, а також підготовку до нього.

Крейг Салліван, експерт з досвіду користувача, вважає, що 40 тестів на місяць - високе навантаження для співробітників. Краще вбити півдня на QA, ніж 2-4 тижні, щоб просто перевірити роботу інструменту.

Проблема №1. A/A тести займають час та трафік, які ви можете витратити на вивчення поведінки відвідувачів сайту.

Проблема №2. І A/B, і A/A потрібно ретельно організовувати та моніторити, щоб не отримати помилкового результату. Як у прикладі від Copyhackers.

Витратити час або ризикнути надійністю ПЗ при ухваленні рішення - вирішувати вам.

Є потенційно менш витратний варіант – A/A/B.

A/A/B vs A/A

Традиційне A/A тестування нічого не говорить про відвідувачів. Але якщо додати у процес ще варіант – інша річ.

A/A = конкурують 2 однакові сторінки.

A/A/B = A/A тест + одна додаткова варіація.

Ви зрозумієте, чи варто довіряти інструменту. Якщо так, вибираєте найкращу версію відповідно до його показань. Якщо ні, їх не варто застосовувати.

Так, потрібно більше часу, щоб досягти статистичної значущості. Зате ви оцінюєте і софт, а якщо він підтвердить свою надійність, – і поведінка відвідувачів.

Висновок

Чи переважують вигоди A/A тестування його недоліки? Немає однозначної відповіді. Проводити тестування щомісяця – зайве. Достатньо – при використанні нового софту (сервісу для проведення тестів). Для тих, кому дуже шкода часу, є компромісний варіант – A/A/B тест.

Якщо ви виключите помилки сьогодні, отримайте більш точні результати у майбутньому.

Високих вам конверсій!

AB test, корисна штука, яка просто повинна бути за замовчуванням в інтернет-проектах. Як проводити та що для цього потрібно?

Сьогодні тестування гіпотез та перевірка ідей, обов'язкова програма. Під це завдання чудово підходить AB test. Давайте розберемо докладніше, що це взагалі таке, у чому користь та які є інструменти.

AB test: що це і навіщо

AB test або Split test - метод маркетингового дослідження, суть якого полягає в тому, що ви берете та порівнюєте кілька варіантів елемента продукту з однією певною зміною. А потім дивіться який із варіантів показав себе краще.

Наприклад, у нас народилася думка, змінити колір кнопки на якійсь сторінці. Ми думаємо, що ця зміна принесе нам більше кліків. Запускаємо обидва варіанти, половині наших користувачів показуємо варіант A, а іншій половині варіант B.

Після якогось часу (тривалість визначається перед запуском тесту) заміряємо результат. Дивимося, який з варіантів краще відпрацював і використовуємо його в роботі. Таким чином ви можете перевіряти практично будь-які гіпотези та дивитися, що краще працює, а що ні.

Що можна аналізувати за допомогою AB Test?

- Конверсії. Кількість успішних цільових дій на вашому сайті. Це може бути натискання на кнопку “Купити”, відвідування якоїсь сторінки або ще щось.

- економіка. Середній чек або обсяг виручки.

- Поведінкові чинники. Глибина перегляду, тривалість сеансу.

Нюанси та тонкощі

- Дуже важливо при тестуванні міняти лише один фактор. Якщо це колір кнопки на лендінгу, то ми тестуємо лише різні кольори кнопок і не змінюємо нічого на сторінках.

- Також і із зовнішніми факторами. Тест запускається в один і той же час за тих самих умов. В іншому випадку ви можете отримати дані, які будуть необ'єктивними.

Вибачте, що перериваю читання. Приєднуйтесь до мого телеграм каналу . Свіжі новини статей, розвиток digital продуктів та growth hack, там все. Чекаю вас! Продовжуємо…

Важливо про дані

Все було б дуже просто, якби не одне "Але". Можна провести AB test, отримати результати, де відверто видно, що один з варіантів значно кращий за інший.

Наприклад, ми показали два варіанти сторінок з різним кольором кнопок по 1000 разів кожен. Проводили тест один тиждень. І отримали такі результати:

При однакових показах банера (це важливо), кількість кліків у варіанта B більше втричі. Робимо висновок, що цей варіант ефективніший і беремо його в робочу версію, а старий видаляємо.

А якщо, наприклад, так?

Чи варто брати варіант B? Чи може це просто похибка? Та й чи достатньо показати 1000 разів кожен із варіантів, щоб ухвалити рішення? Може до нас на сайт за день заходить 10 000 користувачів і вибірка дуже мала, щоб зробити висновок? А якщо, дані які ми аналізуємо, не просто кількість кліків, а середній чек з транзакцій?

Статистика нам на допомогу

Щоб зрозуміти, як влаштований світ цифр та експериментів, давайте трохи розберемо мат.частину. Якщо немає часу та сил, то раджу пропустити цей розділ. Далі, я дам більше прості рішеннязавдання.

Велика спокуса, коли отримали результати експерименту, ухвалити рішення і все, ось воно, "світле майбутнє". Але, якщо копнути трішки глибше, то за тиждень розподіл кліків щодня був нерівномірним. Давайте розпишемо.

У таблиці видно, що кліки щодня розподілені по-різному. Отже, наші значення варіанта A і варіанта B можуть змінюватися щодня. Тобто ми маємо справу з випадковими величинами. Для таких випадків застосовують середні значення. Але якщо ми проведемо експеримент ще раз, то яка ймовірність, що результат повторитися?

Зобразимо на графіку розподіл всіх даних протягом тижня за варіантом A і B.

Якщо ми візьмемо середні величини по кожному з варіантів (це вертикальні смужки посередині двох хвиль), то побачимо, що різниця зовсім невелика. Але існують певні відхилення, більший і менший бік від середнього. Тому ми отримуємо перетин двох хвиль. Чим воно більше, тим менше значимість експерименту і, чим менше перетин, тим вище статистична значимість.

Статистична значимість, те, наскільки вірні отримані результати. Тобто, у нашому прикладі, відповідь на запитання “чи потрібно брати варіант B?”.

Зазвичай, за умовчанням приймають рівень значущості, що дорівнює 95%. Це означає, що ми з 95% ймовірністю хочемо знати, чи варто вибирати інший варіант (B) порівняно. 5%, що залишилися, це ймовірність помилки, яку ми допускаємо або p-value в термінології статистики.

Цікаво, що багато хто забуває перевіряти рівень значущості у своїх експериментах і тим самим може отримувати помилкові дані. 8 із 10 AB тестів проходять повз цю оцінку. ( )

Не вдаватимуся довго в подробиці, як розраховується показник значущості, просто дам інструмент, який порахує все за вас.

Інструменти для розрахунку значущості

Для оцінки значущості даних рекомендую використовуватицей інструмент.

Тут у нас A та B відповідно наші варіанти. А за цифрами:

- Кількість відвідувачів/можна кількість показів вставляти.

- Кількість конверсій. Натиснули кнопку, зареєструвалися. Загалом виконали цільову дію.

- P-value. Можливість помилки, яку ми опускаємо при заданих даних.

- Відповідь на питання чи суттєві, отримані зміни в нашому експерименті.

Приклад: беремо дані про покази та кліки з таблиці, яку показував вище.

Забиваємо їх у сервіс, натискаємо на кнопку “Calculate Significance” та…

Отримуємо відповідь "No" або "Ні" (російською) у нижньому рядку, а трохи вище p-value 0,283. Що це означає? А те, що з ймовірністю 28,3% (0,283*100), якщо ми виберемо варіант “B”, він не принесе жодних істотних результатів.

Щоб експеримент вважався успішним, p-value має бути менше 5%

Є ще один сервіс, в який також вбиваєте дані та дивіться результат, доступнийпосилання.

У цьому будується базовий принцип виміру випадкових величин. Просто в той момент, коли отримаєте результати AB test, проженіть їх через інструмент і подивіться, а на стільки значуще поліпшення від іншого варіанту, щоб брати його в роботу?

Як зрозуміти скільки потрібно даних?

Буває так, що для отримання висновків недостатньо отриманих даних. Для того, щоб зрозуміти, скільки разів потрібно показати сторінку A і B, а потім отримати потрібну кількість даних, використовуйте цейінструмент.

Дуже важливо, повторюся, запускати експеримент за тих самих умов. В ідеалі ми беремо тиждень, на якому немає свят, нічого іншого і паралельно тестуємо варіанти. Повернемося до сервісу.

Завдяки цьому сервісу ви зрозумієте розмір вибірки для кожного варіанта.

Докладніше за пунктами:

- Існуючий рівень конверсії. Або, наприклад, скільки відсотків із усіх користувачів зараз натискають кнопку.

- Мінімально значну зміну, який нас цікавить. Наскільки ми хотіли б змінити базовий показник конверсії.

- Значне відхилення, яке ми запровадили на попередньому кроці, показує, що конверсія може збільшитися, так і зменшитися.

- Ви вибираєте значення: absolute (абсолютний) чи relative (відносний). Вибирайте значення, яке хочете отримати. Якщо у вас baseline рівень конверсій дорівнює 30% (як у прикладі з картинки) і ви хочете підвищити його на 5% за допомогою ab тестів, вибирайте “relative”. Тобто фінальний результат зміни у разі успішності експерименту буде 5% від 30%, тобто 31,5%.

- Розмір вибірки для кожного варіанта. Скільки ми повинні раз показати сторінку окремо A і сторінку B, щоб зробити висновки з експерименту.Дуже важливо! Щоб зробити висновки з експерименту, ми показуємо 24409 разів A і 24409 разів B!

- Статистична значимість. Наскільки точний експеримент хочемо провести.

- Похибка p-value. Якої ймовірності помилки припускаємося.

Чи можна зупиняти експеримент раніше?

Можна, можливо. Існує варіант, коли ми можемо не чекати на закінчення експерименту, а на певному етапі вже зробити висновки. Для цього використовуйте вже відомий інструмент, вкладка “ Sequental Sampling”.

За кроками:

- Вбиваєте свій рівень конверсії зараз. Наприклад 30%, саме стільки зі 100% тих, хто заходить до нас на сторінку, натискає кнопку.

- Набираєте, на скільки ви хотіли б підвищити раніше введений показник. Поставив на 10%. Було 30, хочу до 33 підняти.

- Кількість конверсій одного з експериментів, після якого зупиняємо експеримент і приймаємо рішення.

- Різниця в конверсіях між варіантом A і B, після якої зупиняємо експеримент і беремо, що більше набрав.

- Виставляємо рівень значущості 95% (як належить, див. вище матеріал).

- Встановлюємо похибку p-value (знову ж таки, див. вище матеріал).

Тут немає жодної хитрощів, просто статистика. Використовуйте цей інструмент, коли експерименти займають багато ресурсів (час на розробку, бюджети реклами для перевірки гіпотез і т.д.). Тепер у вас є два правила, за яких ви можете зупиняти експеримент і робити висновки.

Чим проводити AB Test?

Готові рішення:

- Optimizely, vwo.com, zarget.com

- http://alternativeto.net/software/optimizely

- Google Analytics (посилання як проводити)

Власне рішення:

- Пишемо адмінку.

- Пишемо і налаштовуємо кожен експеримент.

Ось для 10 сервісів для AB test. Є з чого вибрати.

Всі

Тепер у вас є загальне уявленняЩо таке AB test, які існують нюанси і якими інструментами його проводити. На закінчення додам що це дослідженнягіпотез є одним з найкорисніших у розвитку digital проекту. Хіба не чудово, що можна перевірити практично будь-яку ідею? Головне правильно, тепер ви знаєте, як.

Оригінальна публікація: http://quality-lab.ru/a-b-testing/

Вступ

Емоції керують людьми, а керування емоціями людей – мрія кожного маркетолога. Як правило, всі нововведення ґрунтуються на суб'єктивному «мені здається, що так буде красивіше/зручніше». Набагато рідше під конкретну зміну проводиться аналіз думки клієнтів. Сподіватися на суб'єктивну оцінку маркетолога можна, але ризиковано. Збирати фокус-групу – затратно. Просто ввести зміну і подивитися, що ж станеться після певного часу, – не науково.

То як же визначити користь змін без втрати клієнтів і часу? Це питання вирішує A/B тестування. Його використання веде до збільшення трафіку клієнтів та ступеня конверсії сайту, до зростання кількості продажів, кліків та лайків.

Що це таке?

Визначення з Wiki:

A/B-тестування(Англ. A / B testing, Split testing) - метод маркетингового дослідження. Суть методу полягає в тому, що контрольна група елементів порівнюється з набором тестових груп (у яких один або кілька показників були змінені) для того, щоб з'ясувати, які зміни покращують цільовий показник. Різновидом A/B-тестування є багатоваріантне тестування.У цьому випадку тестуються не два цілісних варіанти, а відразу декілька елементів продукту або складових частин об'єкта, що досліджується, в різних поєднаннях, при яких кожен тестований елемент може бути двох видів (A або B).

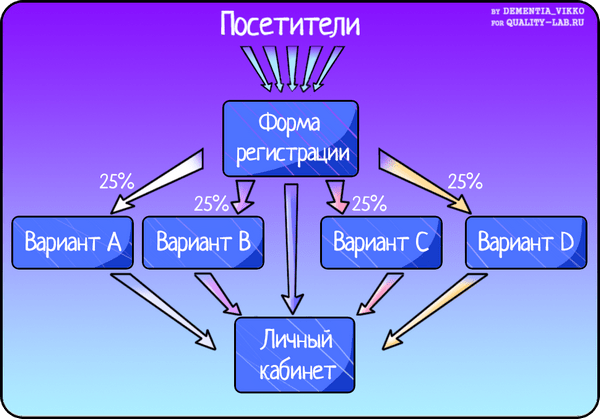

Простіше кажучи весь потік людей на сайті розбивається на дві групи. Однією групі відображається головна сторінка, наприклад, із кнопкою Sign up (Варіант А). Другій групі – та сама сторінка, але з кнопкою Sign up for free (Варіант В). Тестування проводиться сесійно. Наприкінці кожної сесії підбивається підсумок і обчислюється варіант-переможець. Приклад багатоваріантного A/B тестування наведено на схемі:

Як тестувати?

Уявімо собі ситуацію: онлайн-банку потрібно було збільшити кількість заявок на кредитування фізичних осіб. На сайті вже існував банер із закликом заповнити заявку, але маркетологи запропонували його доопрацювати. У відділ тестування було передано два макети для проведення A/B тестування:

Насамперед у відділі тестування визначилися з інструментами, що дозволяють зафіксувати статистику та проаналізувати результат. У мережі можна знайти з десяток платформ для проведення A/B тестування, серед яких найбільш популярні такі:

Всі вони по-своєму зручні та містять достатню кількість функцій для того, щоб стати незамінним помічником під час проведення А/В тестування. Вибір наших тестувальників упав на безкоштовний Google Content Experiment (це рішення входить до складу Google Analytics і вміє самостійно визначати переможця).

За допомогою цієї платформи було створено експеримент для тестування на сайті банку. Для отримання коректних результатів необхідно провести кілька сесій тестування тривалістю в два тижні. У першу сесію тестувальники отримали неоднозначний результат (конверсія у двох варіантах була майже рівна, тому визначити переможця A/B тестування не вдалося). Після серії подібних експериментів, тестувальникам таки вдалося отримати чіткий результат тестування: переміг другий варіант банера (з фотографією родини). Можливо, це було пов'язано з тим, що остання сесія припала на новорічні канікули: ЦА була лояльнішою та дружелюбнішою.

Підсумок історії: якщо раніше заявку на кредит подавали 2 з 10 банер, що переглянули, то тепер – 4 з 10.

Повернімося до інструментів A/B тестування. Для інструментів, які не вміють визначати переможця, підсумки сесії А/В тестування можна обробити вручну або за допомогою калькулятора. При ручній обробці необхідно врахувати співвідношення конверсії до відвідувань сайту. Це трудомісткий процес, який вимагатиме від вас зосередженості та точності; він може затягтися на кілька годин. Набагато зручніше скористатися готовим рішенням – калькулятором: вам достатньо буде запровадити результати тестування та отримати варіант-переможець. Майже всі калькулятори для тестування A/B англомовні, але є і

Сергій Гудков, спеціаліст з розробки та просування сайтів (понад 160 сайтів та 250 спліт-тестів), керівникСonversion42

Андрій Осипов, сертифікований тренер Google, практикуючий веб-аналітик, автор блогу«Веб-аналітика та результат»

Ми часто отримуємо запити на тексти для тестування А/В. З якою метою є сенс його проводити?

А/В-тест можна проводити практично для будь-яких змін на сайті. Адже тест – це можливість достовірно дізнатися, наскільки вони є ефективними.

Якщо у вас сторінка з описом послуги, то основний контент, що продає – це саме текст. Відвідувачі на підставі тексту вирішують залишити заявку чи ні. В даному випадку текст є основним об'єктом тестування:

- які характеристики вказувати у тексті, а які ні;

- які заклики використовувати у тексті;

- в якому стилі має бути написаний текст і т.д.

Запит "текст для А/В-тестування" звучить не дуже. Краще замовляти просто новий текст, що більш продає. А вимірювати характеристики тексту, що продають, можна за допомогою тестування.

A/B-тестування для сайтів: чи потрібно тестувати текст, дизайн, сторінку в цілому, «продаючість» тексту чи сторінки?

Тестувати можна будь-що.

Якщо ви вважаєте, що кнопка «Купити» непомітна, тестуйте лише зміну кнопки. Якщо ви зробили новий дизайн сторінки, можна випробувати різницю між двома дизайнами.

Іноді у тесті порівнюють два сайти. Це дуже спірне заняття – якщо вам цікаво, пропонуємо обговорити це питання на вебінарі конкретніше.

Можна тестувати і один елемент за раз, і відразу цілі сторінки. Від чого це залежить? Все дуже просто. Якщо у вас є 10/30/100 дрібних змін, і ви впевнені, що кожна з них збільшить конверсію, поєднуйте це все в один тест. Якщо запускати їх окремо, то робити навіть 30 тестів – це може бути дуже довго та не надто ефективно. І навпаки. Якщо є одна важлива зміна, і ви сумніваєтеся щодо реакції відвідувачів сайту на нього, запускайте один тест на одну зміну.

Які дані (максимум) можна отримати під час А/В-тестування?

Сенс А/В-тестів вкрай простий: ділимо відвідувачів на дві групи – одній із них показуємо варіант А, інший – варіант У.

Основним результатом тесту вважається різниця між поведінкою користувачів. Наприклад, ми хочемо дізнатися, як зміниться конверсія інтернет-магазину.

Також при інтеграції А/В-тесту з системами веб-аналітики, зокрема Google Analytics, можна побачити різницю в поведінці за всіма параметрами: глибина і час відвідування, відвідування конкретних сторінок, показники відмов, досягнення всіх цілей і т.д.

Які послуги можуть допомогти правильно провести A/B-тест?

Правильність запуску завжди залежить від вас. Сервіси це інструмент. Як молоток. Якщо ви вмієте користуватися ним, то у вас все вийде.☺

Найпоширеніші послуги для запуску А/В-тестів:

- Google Analytics (безкоштовний);

- VWO (платний, https://vwo.com/);

- Optimizely (платний, https://www.optimizely.com/).

Більшість потреб вистачає Google Analytics. Ми самі його часто використовуємо і рекомендуємо.

Скільки елементів можна за один раз тестувати? Чи правильно порівнювати 2 тексти, які мають більше 1–2 елементів?

Так можна. Найголовніше, треба розуміти, як ці елементи вплинуть на конверсію та чому. У вас має бути робоча гіпотеза.

Коли ви проводите дуже багато тестів, бувають моменти, коли ідей та гіпотез немає. Такий собі провал. У такі моменти можна тестувати за принципом «А давайте зробимо та подивимося… Цікаво ж».☺

В А/В-тестуванні найцінніше – це час та обсяг трафіку. Іншими словами, ви можете провести обмежену кількість тестів у обмежений час. Тому простий сайт без тесту – це розтрата безцінного ресурсу.

Яких умов слід дотримуватись для правильного А/В-тестування? Який мінімум переглядів/візитів/уніків?

Щоб тест вийшов хорошим, має дотримуватись досить багато умов. Назвемо основні з них:

- Має бути цільовий показник, наприклад, загальна конверсія інтернет-магазину чи лендингу, показник відмов якоїсь групи сторінок, клікабельність кнопки «Купити» тощо.

- Тест має завершитися перемогою одного із варіантів зі статистичною достовірністю. Це означає, що цей варіант з дуже великою ймовірністю дійсно кращий.

- Тест має тривати ~2 цикли прийняття рішення про купівлю. Наприклад, відомо, що дівчата обирають прикраси близько тижня. Значить, мінімальний термін тесту становитиме 2 тижні. Загалом ми рекомендуємо тримати тести від 1 до 3 тижнів.

Питання «А скільки треба трафіку?» не зовсім коректний. Тривалість тесту залежить від кількості трафіку та дельти цільового показника. Наприклад, тест зі збільшенням конверсії з 1% до 2% завершиться швидше ніж тест, де зростання буде з 1% до 1,2%. Також тест на сайті з відвідуваністю 1000 осіб на добу йтиме довше, ніж на сайті із 5000 відвідувачів.

Як інтерпретувати одержані результати для подальшої перевірки гіпотез?

Інтерпретація результатів є досить простою. варіант, Що Виграв, треба впровадити.☺

У будь-якому випадку, незалежно від результатів тесту, ви повинні оцінити поведінку людей на новому варіанті. Це дасть вам нові ідеї для нових гіпотез.

Які основні помилки допускаються при А/В-тестуванні?

Помилок багато. ТОП-3 із них:

- Тести закінчують раніше досягнення статистичної достовірності. Це може дуже дорого коштуватиме бізнесу. Впроваджуючи зміни після таких тестів, ви не знаєте, зробили ви краще чи гірше.

- Тестуються необґрунтовані ідеї, підказані прибиральницею із сусіднього офісу. По суті, марно витрачаються безцінний час сайту та ресурси компанії на підготовку та реалізацію тесту.

- Чи не відстежуються показники під час тесту. Часто буває, що під час запуску програмісти помилилися, і одна варіація працює з помилкою. Якщо не контролювати тест, то дізнатися про це можна через 2-3 тижні. Це марна трата часу та ресурсів.

A/B тестування

A/B тестування як спосіб керування конверсією

A/B тестування - один із найефективніших маркетингових інструментів, який використовується для оцінки та управління конверсією сайту. Інструмент полегшить роботу маркетолога – він убудований у продукт і не потребує додаткових налаштувань. У продукті є шість готових сценаріїв A/B тестування - новий дизайн, головна сторінка, детальна картка товару, сторінки кошика, сторінка оформлення замовлення і довільно обрана сторінка. На підставі тестування буде вибрано найефективніший варіант для показу.

Скористатися інструментом може звичайний контент-менеджер, оскільки система все робить сама і не потрібно програмувати нічого. Достатньо вибрати один із попередньо встановлених тестів, запустити його та отримати докладні звіти щодо ефективності.

Навіщо потрібні А/В тести

Як зміни можуть позначитися на конверсії?А/В тестування - один з кращих способівдля збільшення конверсії сторінок та інтернет-магазину. Головна мета А/В тестування – з'ясувати, які саме складові сайту подобаються відвідувачам більше, працюють краще, а отже, і підвищують конверсію. Особливо ефективні А/В тести для сайтів із великим трафіком.

Що змінити?

Бажаєте щось змінити на сайті для покращення конверсійних показників? Проведіть А/В тестування, з'ясуйте, як зміни позначаться цих показниках.

Навіть невеликі експерименти із контентом сайту можуть змінити конверсію. У більшу чи меншу сторону? Пройдіть випробування перед тим, як радикально змінити, наприклад, свої рекламні пропозиції.

Зробити А/В тест вручну дуже складно для звичайного користувача. Збирати дані, проводити аналіз і обчислювати найбільш вдалі варіанти сторінок - усе це пов'язано з великими витратами праці. Звертатися до послуг спеціальних сервісів – довго та дорого.

У продукті – готові А/В тести – абсолютно безкоштовно!

Протестуйте новий шаблон сайту

Готові А/В тести

Готові А/В тести

Не потрібно програмувати, не потрібно налаштовувати!Провести A/B тестування самостійно дуже складно. Незважаючи на те, що це один із найефективніших інструментів, роблять це вкрай рідко. «1С-Бітрікс» представляє унікальний інструмент, що дозволяє кожному клієнту за 5 хвилин провести A/B тестування самотужки.

Шаблони готових тестів

У вашому розпорядженні – вбудовані інструменти А/В тестування. Тепер ви можете легко перевірити, який варіант сторінки працює ефективніше. З продуктом "1С-Бітрікс: Управління сайтом" ви отримуєте комплект готових тестів. Всі тести вбудовані в продукт і не потребують додаткових налаштувань.

Тестуйте, вносите зміни на сайт та отримуйте прибуток.

6 сценаріїв A/B тестування:

- Новий дизайн

- Головна сторінка

- Детальна картка товару

- Сторінки кошика

- Сторінка оформлення замовлення

- Довільна обрана сторінка

Список попередньо встановлених тестів поповнюватиметься!

Не треба програмувати!

Потрібний тестдостатньо вибрати зі списку встановлених та запустити. Для виконання тесту достатньо знань та прав звичайного контент-менеджера.

Пройдіть тест перед зміною дизайну

Скористатися інструментом може звичайний користувач, оскільки система все робить сама і не вимагає програмування. Достатньо вибрати один із встановлених тестів, запустити його та отримати на руки докладні звіти щодо ефективності. Система сама скопіює потрібну вам сторінку!

Звіти та аналітика

Детальні звіти щодо ефективності

Повна аналітика для вибору найкращого варіанту!Дізнайтеся за допомогою нового інструменту, як позначиться на конверсії магазину, зміна дизайну сайту, перебудова головної сторінки, нове подання картки товару, інше сортування товару в каталозі та інші зміни. Достатньо вибрати та запустити потрібний тест.

- Графіки

- Зведені дані

- Вирва

Слід враховувати, що конверсія вираховуватиметься за тими лічильниками, які були вибрані у налаштуваннях модуля .

Звіти з тестів У будь-який момент після запуску тесту, навіть не чекаючи його закінчення, можна переглянути звіт про тестування.

Зробіть свій інтернет-магазин найпродавшим!

Будь-який маркетолог може сам запустити тестування за 5 хвилин!

«B» - це те, з чим ви експериментуватимете (новий дизайн).